-

漳州龙江岁月“龙马踏春·潮趣龙江”马年春节系列活动启幕

2026年2月17日至21日(农历正月初一至初五),漳州高新区龙江岁月以“龙马踏春·潮趣龙江”为主题,掀起一场为期五天的新春文旅热浪。这场深度融合生肖马年、非遗闽南与科技潮玩的年度盛典,不设门票、全龄...

-

春节 “吃瘦” 指南:瑜伽专家揭秘6大科学饮食原则,让你过节不囤脂

春节 “吃瘦” 指南:瑜伽专家揭秘6大科学饮食原则,让你过节不囤脂春节将至,丰盛的家宴和亲友聚餐成为节日的重要组成部分。专家指出,春节期间人均热量摄入较平日增加 30%,体重平均增长 1-2 公斤,“...

-

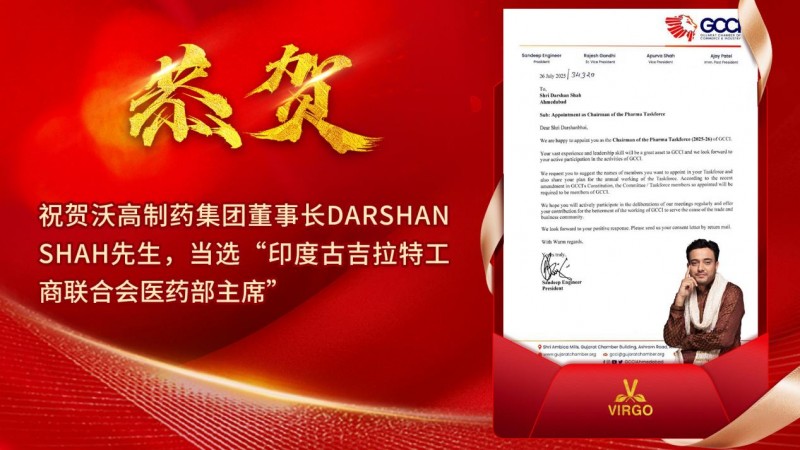

黄金雄马新春特惠 -----恭贺大山当选医药部主席

印度古吉拉特邦工商联合会医药部迎来新主席,沃高制药第四代传承人大山·沙阿在新春致辞中表达对中国市场的重视,并宣布【黄金雄马胶囊】新春优惠计划。近日获悉,印度沃高制药董事大山·沙阿先生当选古吉拉特邦工商...

-

凝聚湾区力量 共筑创新高地|南山区沙河街道商会正式成立

2月4日下午,南山区沙河街道商会成立大会暨第一次会员大会在沙河街道人大代表之家举行。深圳市工商联党组成员、专职副主席耿绍炜,沙河街道党工委副书记、办事处主任刘春晓,南山区工商联党组成员、专职副主席肖晓...

-

渠道破局·深耕湾区丨定档11月,2026创食展焕新升级,共赴节令产业万亿商机

节假日经济浪潮席卷而来,大湾区消费活力持续拉满!健康化、场景化新风向,正重塑烘焙休闲食品产业新赛道。2026中国创新食品大会暨中国烘焙休闲食品展,将于11月5日-7日在广东东莞厚街·广东现代国际展览中...

-

善聚羊城,共赴新程——第九届公益事业大典在广州圆满落幕 鹏艾堂(深圳)健康养生管理有限公司董事长李泽德董事长受邀出席

凝聚公益力量,传承公益薪火。2026年1月26日,第九届公益事业大典在广州凤凰城圆满落幕。来自全国各地及海外的学术界、商界、文艺界、媒体等各界公益相关代表齐聚一堂,分享公益事迹,交流成功经验,共同探讨...

-

百年花艺焕新彩,粤赏粤美正当时 2026广州“花城花街”第三场花卉主题活动即将浪漫启幕

千年商都,百年花艺;花开不败,历久弥新。2026年1月31日,广州花城越秀展示窗口——北京路花城花街,将迎来“花城花街”系列第三场花卉主题活动:“百年花艺,粤赏粤美”。本次活动以“百年花艺文化”为根脉...

-

郭坚林会长受邀出席第九届公益事业大典

凝聚公益力量,传承公益薪火。2026年1月26日,第九届公益事业大典在广州凤凰城圆满落幕。来自全国各地及海外的学术界、商界、文艺界、媒体等各界公益相关代表齐聚一堂,分享公益事迹,交流成功经验,共同探讨...

-

亮晶 2025:一场改变卫浴行业的材料革命

当卫浴空间从功能载体演变为生活美学的重要组成,材料的创新便成为这场变革的核心驱动力。2025 年,在全球卫浴产业向绿色化、高端化迈进的关键节点,亮晶集团以一场深刻的 “材料革命”,给出了自己的答案。作...

-

亮晶集团:全球卫浴纯亚克力板材领先制造商

在高端卫浴制造领域,材料的品质直接决定了产品的寿命、美感与用户体验。作为全球卫浴纯亚克力板材的领先制造商,亮晶集团始终站立于材料创新的前沿,以卓越的研发实力、严格的生产标准和前瞻性的行业视野,为全球高...